Supermicro aumenta o portfólio de produtos otimizados para IA com uma nova geração de sistemas e arquiteturas de rack com as novas soluções de arquitetura NVIDIA Blackwell

Soluções poderosas e eficientes em termos de energia para CSPs e NSPs de grande escala incorporam uma pilha completa de GPUs e CPUs NVIDIA de última geração com a plataforma NVIDIA Quantum X800 e NVIDIA AI Enterprise 5.0

SAN JOSE, Califórnia, 19 de março de 2024 /PRNewswire/ -- NVIDIA GTC 2024, -- Supermicro, Inc. (NASDAQ: SMCI), fornecedora de soluções totais de TI para IA, nuvem, armazenamento e 5G/Edge, está anunciando novos sistemas de IA para IA generativa em grande escala com a próxima geração de produtos de data center da NVIDIA, incluindo o mais recente NVIDIA GB200 Grace™ Blackwell Superchip, as GPUs NVIDIA B200 Tensor Core e B100 Tensor Core. A Supermicro está aprimorando seus atuais sistemas NVIDIA HGX™ H100/H200 8-GPU para estarem prontos para o NVIDIA HGX™ B100 8-GPU e aprimorados para suportar o B200, resultando em um tempo reduzido para entrega. Além disso, a Supermicro fortalecerá ainda mais sua ampla linha de sistemas NVIDIA MGX™ com novas ofertas que apresentam o NVIDIA GB200, incluindo o NVIDIA GB200 NVL72, uma solução completa em nível de rack com 72 GPUs NVIDIA Blackwell. A Supermicro também está adicionando novos sistemas à sua linha, incluindo o sistema 4U NVIDIA HGX B200 8-GPU com resfriamento a líquido.

"Nosso foco na arquitetura de blocos de construção e na TI total em escala de rack para IA nos permitiu projetar sistemas de última geração para os requisitos aprimorados das GPUs baseadas na arquitetura NVIDIA Blackwell, como nosso novo sistema baseado em NVIDIA HGX B200 8-GPU resfriado a líquido 4U, como também nossos racks resfriados a líquido direto para chip totalmente integrados com NVIDIA GB200 NVL72", disse Charles Liang, presidente e CEO da Supermicro. "Esses novos produtos foram criados com base na arquitetura de sistema HGX e MGX comprovada da Supermicro e da NVIDIA, otimizados para os novos recursos das GPUs NVIDIA Blackwell. A Supermicro tem a experiência para incorporar GPUs de 1kW em uma ampla gama de sistemas resfriados a ar e a líquido, como também a capacidade de produção em escala de rack de 5.000 racks/mês e prevê ser a primeira no mercado a implantar clusters de rack completos com GPUs NVIDIA Blackwell."

A tecnologia de resfriamento a líquido direto ao chip da Supermicro permitirá o aumento da potência de design térmico (TDP) das GPUs mais recentes e fornecerá todo o potencial das GPUs NVIDIA Blackwell. Os sistemas HGX e MGX da Supermicro com NVIDIA Blackwell são os blocos de construção para o futuro da infraestrutura de IA e proporcionarão um desempenho inovador para treinamento de IA com vários trilhões de parâmetros e inferência de IA em tempo real.

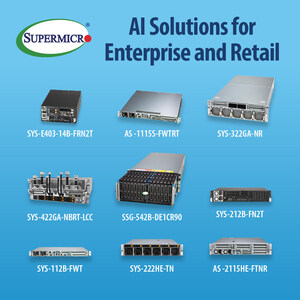

Uma ampla variedade de sistemas Supermicro otimizados para GPU estará pronta para a GPU NVIDIA Blackwell B200 e B100 Tensor Core e validada para o mais recente software NVIDIA AI Enterprise, que adiciona suporte para microsserviços de inferência NVIDIA NIM . Os sistemas Supermicro incluem:

- Sistemas NVIDIA HGX B100 8-GPU e HGX B200 8-GPU

- Sistema de GPU PCIe 5U/4U com até 10 GPUs

- SuperBlade® com até 20 GPUs B100 para gabinetes 8U e até 10 GPUs B100 em gabinetes 6U

- 2U Hyper com até 3 GPUs B100

- Sistemas Supermicro 2U x86 MGX com até 4 GPUs B100

Para o treinamento de modelos de IA fundamentais e massivos, a Supermicro está preparada para ser a primeira no mercado a lançar os sistemas NVIDIA HGX B200 8-GPU e HGX B100 8-GPU. Esses sistemas contam com 8 GPUs NVIDIA Blackwell conectadas por meio de uma interconexão NVIDIA® NVLink® de quinta geração de alta velocidade a 1,8 TB/s, dobrando o desempenho da geração anterior, com 1,5 TB de memória total de alta largura de banda e fornecerão resultados de treinamento 3 vezes mais rápidos para LLMs, como o modelo GPT-MoE-1.8T, em comparação com a geração da arquitetura NVIDIA Hopper. Esses sistemas apresentam uma rede avançada para escalonar para clusters, suportando as opções NVIDIA Quantum-2 InfiniBand e NVIDIA Spectrum-X Ethernet com uma proporção de 1:1 GPU para placa de rede.

"A Supermicro continua a trazer ao mercado uma incrível variedade de servidores de plataforma de computação acelerada que são ajustados para treinamento e inferência de IA que podem atender a qualquer necessidade no mercado hoje, disse Kaustubh Sanghani, vice-presidente de Gerenciamento de Produtos de GPU da NVIDIA. "Trabalhamos em estreita colaboração com a Supermicro para trazer as soluções mais otimizadas para os clientes."

Para as cargas de trabalho de inferência LLM mais exigentes, a Supermicro está lançando vários novos sistemas MGX construídos com o NVIDIA GB200 Grace Blackwell Superchip, que combina uma CPU NVIDIA Grace com duas GPUs NVIDIA Blackwell. Os sistemas NVIDIA MGX com GB200 da Supermicro proporcionarão um grande salto no desempenho para inferência de IA com até 30 vezes mais velocidade em comparação com o NVIDIA HGX H100. A Supermicro e a NVIDIA desenvolveram uma solução em escala de rack com o NVIDIA GB200 NVL72, conectando 36 CPUs Grace e 72 GPUs Blackwell em um único rack. Todas as 72 GPUs estão interconectadas com o NVIDIA NVLink de quinta geração para comunicação GPU-para-GPU a 1,8 TB/s. Além disso, para cargas de trabalho de inferência, a Supermicro está anunciando o ARS-221GL-NHIR, um servidor 2U baseado na linha de produtos GH200, que terá dois servidores GH200 conectados por meio de uma interconexão de alta velocidade de 900 Gb/s. Visite o estande da Supermicro no GTC para saber mais.

Os sistemas Supermicro também serão compatíveis com a futura plataforma NVIDIA Quantum-X800 InfiniBand, que consiste no switch NVIDIA Quantum-X800 QM3400 e no SuperNIC800, e com a plataforma NVIDIA Spectrum-X800 Ethernet, que consiste no switch NVIDIA Spectrum-X800 SN5600 e no SuperNIC800. Otimizados para a arquitetura NVIDIA Blackwell, o NVIDIA Quantum-X800 e o Spectrum-X800 oferecerão o mais alto nível de desempenho de rede para infraestruturas de IA.

Para obter mais informações sobre as soluções NVIDIA da Supermicro, acesse https://www.supermicro.com/en/accelerators/nvidia

A próxima linha de sistemas da Supermicro com NVIDIA B200 e GB200 consiste em:

- Os sistemas NVIDIA HGX B200 8-GPU da Supermicro, resfriados a ar e a líquido, destinam-se ao mais alto desempenho de treinamento de IA generativa. Esse sistema apresenta 8 GPUs NVIDIA Blackwell conectadas via NVLink de quinta geração com um pool de 1,5 TB de memória de alta largura de banda (até 60 TB/s) para acelerar as cargas de trabalho de treinamento de IA.

- O sistema de treinamento de IA mais vendido da Supermicro, o sistema 4U/8U com NVIDIA HGX H100/H200 8-GPU, será compatível com a futura HGX B100 8-GPU da NVIDIA.

- Uma solução de nível de rack da Supermicro que apresenta sistemas Superchip GB200 como nós de servidor com 2 CPUs Grace e 4 GPUs NVIDIA Blackwell por nó. O resfriamento a líquido direto ao chip da Supermicro maximiza a densidade com 72 GPUs GB200 de 192 GB (1200W TDP por GPU), tudo em um único rack ORV3 de 44U.

Supermicro no GTC 2024

A Supermicro demonstrará um portfólio completo de sistemas de GPU para IA no evento GTC 2024 da NVIDIA, de 18 a 21 de março, no Centro de Convenções de San Jose. Visite a Supermicro no estande nº 1016 para ver as soluções criadas para uma ampla variedade de aplicativos de IA, incluindo o treinamento de modelos de IA generativa, inferência de IA e IA de ponta. A Supermicro também apresentará duas soluções em nível de rack, incluindo um rack conceitual com sistemas que apresentam o próximo NVIDIA GB200 com 72 GPUs com resfriamento a líquido interconectadas com NVLink de quinta geração.

As soluções da Supermicro que estarão em exibição no GTC 2024 incluem:

- Rack de treinamento de IA com resfriamento a líquido da Supermicro com 8 sistemas 4U 8-GPU com NVIDIA HGX H200 8-GPUs

- Rack conceito ORV3 da Supermicro com nós de sistema MGX resfriados a líquido, hospedando um total de 72 NVIDIA GB200 Superchips conectados via NVLink de quinta geração

- Sistemas MGX da Supermicro, incluindo o sistema 1U Grace Hopper Superchip NVIDIA GH200 com resfriamento a líquido

- Sistema Hyper-E de profundidade curta da Supermicro para fornecer computação de GPU na borda

- Sistema de armazenamento all-flash Supermicro Petascale para pipelines de dados de IA de alto desempenho

Sobre a Super Micro Computer, Inc.

Supermicro (NASDAQ: SMCI) é líder mundial em soluções totais de TI otimizadas para aplicativos. Fundada e operando em San José, Califórnia, a Supermicro está comprometida em proporcionar inovação pioneira ao mercado para infraestrutura de TI empresarial, nuvem, IA e 5G de telecomunicações / borda. Somos um fabricante de soluções totais de TI com servidores, IA, armazenamento, IoT, sistemas de comutação, software e serviços de suporte. A experiência em design de placas-mãe, energia e chassis da Supermicro permite que nosso desenvolvimento e produção seja ainda maior, ao possibilitar inovação de última geração, desde a nuvem até a borda, a nossos clientes internacionais. Nossos produtos são projetados e fabricados internamente (nos EUA, Taiwan e Países Baixos), aproveitando as operações internacionais para obter escala e eficiência, sendo otimizados para melhorar o TCO e reduzir o impacto ambiental (computação ecológica). O premiado portfólio Server Building Block Solutions® permite que os clientes otimizem sua carga de trabalho e aplicação com exatidão, ao selecionar entre uma ampla família de sistemas construídos a partir de nossos blocos de construção flexíveis e reutilizáveis, os quais suportam um conjunto abrangente de soluções de fatores de forma, processadores, memória, GPUs, armazenamento, rede, energia e resfriamento (ar condicionado, resfriamento ao ar livre ou resfriamento a líquido).

Supermicro, Server Building Block Solutions e We Keep IT Green são marcas comerciais ou marcas registradas da Super Micro Computer, Inc.

Todas as outras marcas, nomes e marcas registradas são propriedade de seus respectivos proprietários.

SMCI-F

Foto - https://mma.prnewswire.com/media/2365522/4118657.jpg

Logotipo - https://mma.prnewswire.com/media/1443241/Supermicro_Logo.jpg

FONTE Super Micro Computer, Inc.

Partilhar este artigo